Verglichen mit anderen Branchen ist der Einsatz von Künstlicher Intelligenz (KI) im Laborumfeld noch zurückhaltend. Doch ein Gegentrend ist erkennbar. Für die Entwicklung wirtschaftlich sinnvoller KI existieren etablierte Vorgehensweisen aus anderen Industriezweigen. Wer sie kennt, hat einen Wettbewerbsvorteil.

1979 kam es zu einem aussergewöhnlichen Phänomen: Personen mit rechenintensiven Jobs erledigten ihre Aufgaben plötzlich viel schneller als bisher – und erzielten dabei auch noch perfekte Ergebnisse. Sie nutzten eine für damalige Zeiten neuartige Technologie namens Visicalc, den Vorläufer des Excel. Einmal mit Rechenwegen ausgestattet, konnte es die Berechnungen deutlich schneller und besser ausführen als das Fachpersonal, das dafür im Gegenzug mehr Zeit für andere wertschöpfende Tätigkeiten hatte.

Chatbots im industriellen Einsatz

45 Jahre später steht der Welt eine ähnlich epochale Technologie zur Verfügung wie seinerzeit mit dem aufkommenden Einsatz von Computern: Künstliche Intelligenz (KI). Besonders seit das Unternehmen OpenAI mit dem Chatbot ChatGPT ein neues Level generativer KI der Allgemeinheit zugänglich gemacht hat, ist das Thema auch in der Wahrnehmung der breiten Öffentlichkeit rasant gestiegen. KI-Start-ups spriessen wie Pilze aus dem Boden und Weltkonzerne wie Alphabet, Meta und Adobe statten ihre Anwendungen in rekordverdächtigem Tempo mit KI-Systemen aus, die menschliche Sprache verstehen und imitieren, Bilder und Videos wie aus dem Nichts kreieren und menschliche Stimmen fast perfekt nachahmen.

Vor der Industrie macht dieser Hype ebenfalls keinen Halt, stellt Alexander Brendel, Director Life Science bei der infoteam Software AG, fest. Seit über 40 Jahren entwickelt das Unternehmen im Kundenauftrag Embedded Software, Middleware und Anwendungssoftware für verschiedene Märkte, darunter auch die Laborbranche – seit 15 Jahren zählen Systeme künstlicher Intelligenz zum Portfolio. In jüngster Zeit steigt vor allem die Nachfrage nach Einsatzmöglichkeiten für generative KI. «ChatGPT ist ein Large Language Model, kurz LLM. Diese Technologie haben wir auch schon in der Zeit vor ChatGPT bei unseren Kunden eingesetzt, wenn es das richtige Werkzeug für die gestellte Aufgabe war. ChatGPT selbst bietet nun in einem definierten Einsatzgebiet ein neues Qualitätslevel, weshalb wir es ebenfalls seit einigen Monaten in Kundenprojekten nutzen, beispielsweise um Servicemeldungen zu kategorisieren», berichtet Alexander Brendel. In diesem Szenario liest die KI Tausende von Fehlermeldungen, die beim technischen Support ankommen, und findet die eine Meldung, die einen bislang unbekannten Bug beschreibt. Ein enormer Zeit- und Qualitätsvorteil zu früher.

Ein weiterer Anwendungsfall ist der Einsatz von ChatGPT im Wissensmanagement: «Bislang mussten Menschen in grossen Wissensdatenbanken nach dokumentiertem Wissen suchen, um eine exakte Fragestellung zu klären. Heute können Anwenderinnen und Anwender der KI eine Frage in eigenen Worten stellen und die KI findet in der Wissensdatenbank die gesuchte Antwort und liefert zusätzlich die Quelle, sodass ein Nachprüfen möglich ist», so Brendel weiter. Wertvolle Arbeitszeit gehe so nicht für die manuelle Suche verloren, sondern stehe für wertschöpfende Aufgaben zur Verfügung. Wichtig sei, «dass ChatGPT und allgemein LLMs zwar aktuell in aller Munde sind, tatsächlich stellen sie aber nur eine kleine Teilmenge im gesamten KI- und Data-Science-Kosmos dar», erklärt Brendel. Welche KI die richtige für ein konkretes Projekt ist, richtet sich nicht nach Trends oder der Branche, in der sie zum Einsatz kommt, sondern nach der Aufgabenstellung.

KI in der Qualitätskontrolle

Dass KI im Laborumfeld bislang kaum eine Rolle spielt, überrascht auf den ersten Blick, denn grundsätzlich sind die Einsatzmöglichkeiten gleichermassen vielseitig und lukrativ wie in allen anderen Industriezweigen. Doch auch in der Laborbranche erkennen nun die ersten Firmen, dass jetzt der Zeitpunkt gekommen ist, um mit KI wettbewerbsfähig zu bleiben oder sogar neue Marktvorteile zu erschliessen. Das gilt sowohl für Grossinvestitionen, wie sie beispielsweise BioNTech durch die Beteiligung an InstaDeep getätigt hat, als auch für vergleichsweise «kleine», individuelle KI-Lösungen, mit denen Labore ihren Alltag optimieren oder ihr Portfolio erweitern können.

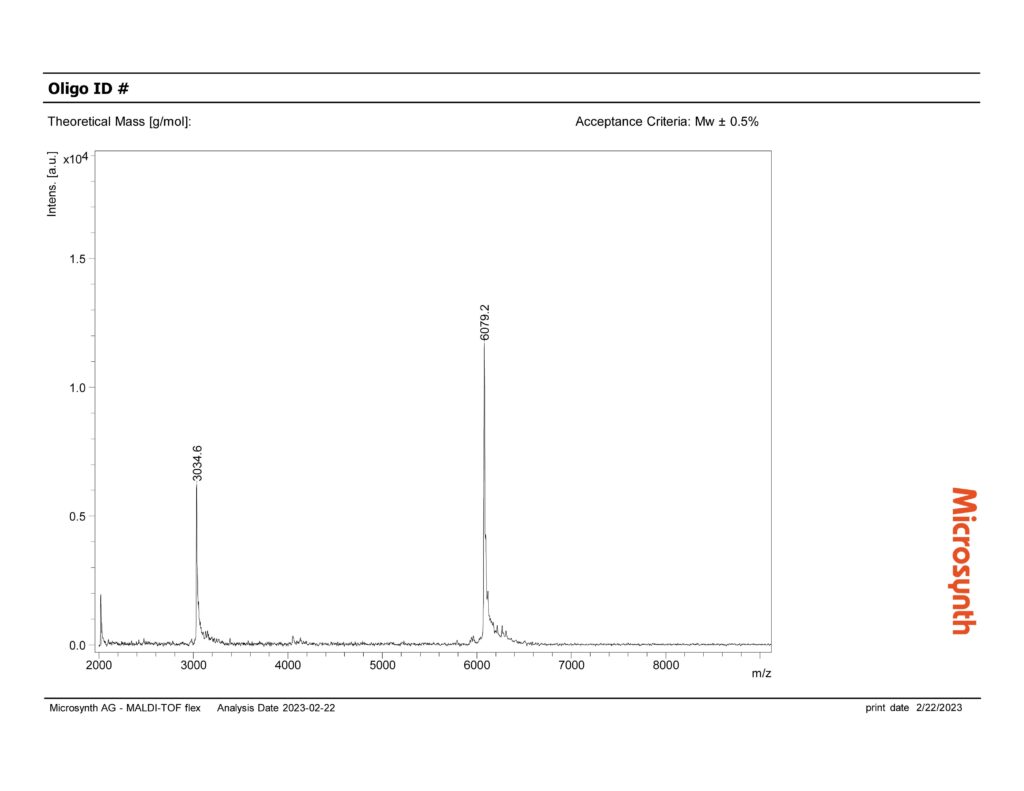

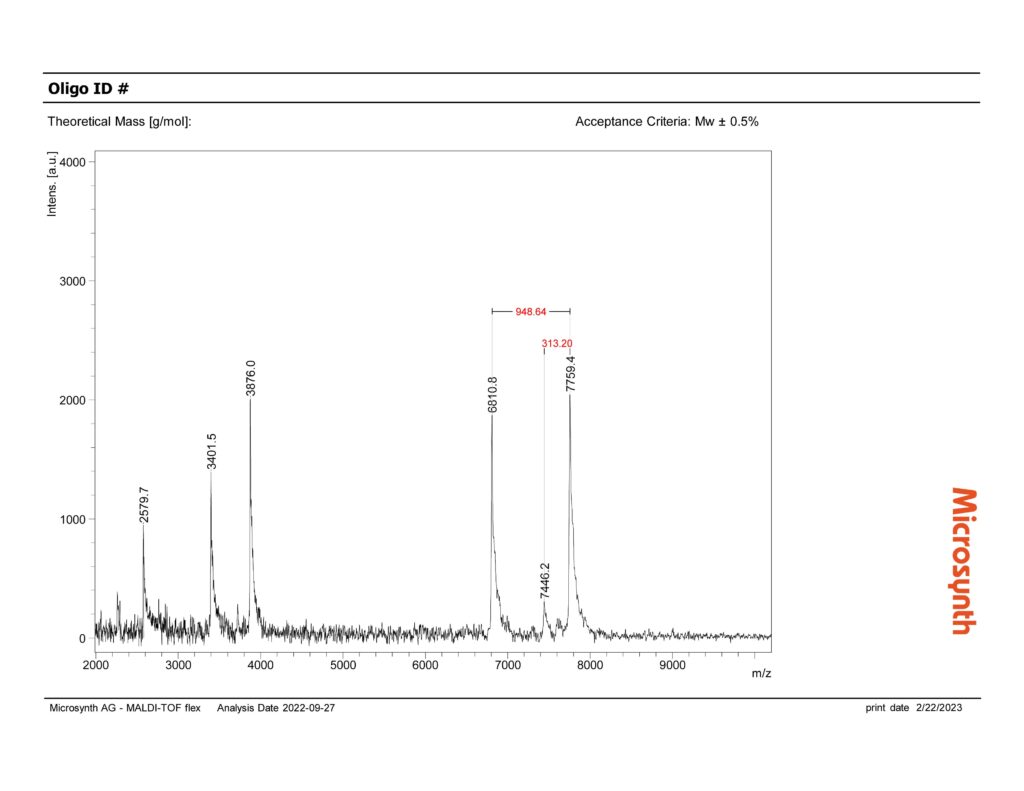

Einer dieser Vordenker hat seinen Hauptsitz in Balgach (SG) in der Schweiz. Die dort ansässige Microsynth AG ist Pionierin und Spezialistin für passgenaue, kundenspezifische DNA- und RNA-Oligonukleotidsynthesen. Bevor die produzierten «Oligos» an die Kunden gehen, durchlaufen sie eine strenge Qualitätskontrolle: Mittels Massenspektrometrie ermitteln Expertinnen und Experten, ob die produzierten Oligos in ihrer Zusammensetzung den strengen Kunden- und Qualitätsvorgaben entsprechen (Abb. 1 und 2). Hierfür sichtet eine Person jedes erzeugte Massenspektrum und beurteilt, ob die Spitzen (Peaks) in der Messung dem zu erwartenden Bild entsprechen oder ob es aussergewöhnliche Peaks gibt. Bei Microsynth fallen pro Tag bis zu 2000 Messungen an, die innerhalb weniger Stunden und vor dem Versand der Oligos begutachtet werden müssen – eine extrem wichtige Arbeit, aber auch ein enormer Zeit- und Kostenfaktor. Die Verantwortlichen stellten sich deshalb die Frage, ob eine KI die Qualitätskontrolle unterstützen oder sogar automatisiert übernehmen könnte. Die Idee: Eine KI prüft die Messergebnisse und holt nur dann menschliche Unterstützung zu Hilfe, wenn die Kontrolle nicht den Erwartungen entspricht. So würde die KI den Bewertungsprozess beschleunigen und die menschlichen Expertinnen und Experten hätten mehr Zeit für andere wertschöpfende Arbeiten.

Voraussetzungen und Entwicklung

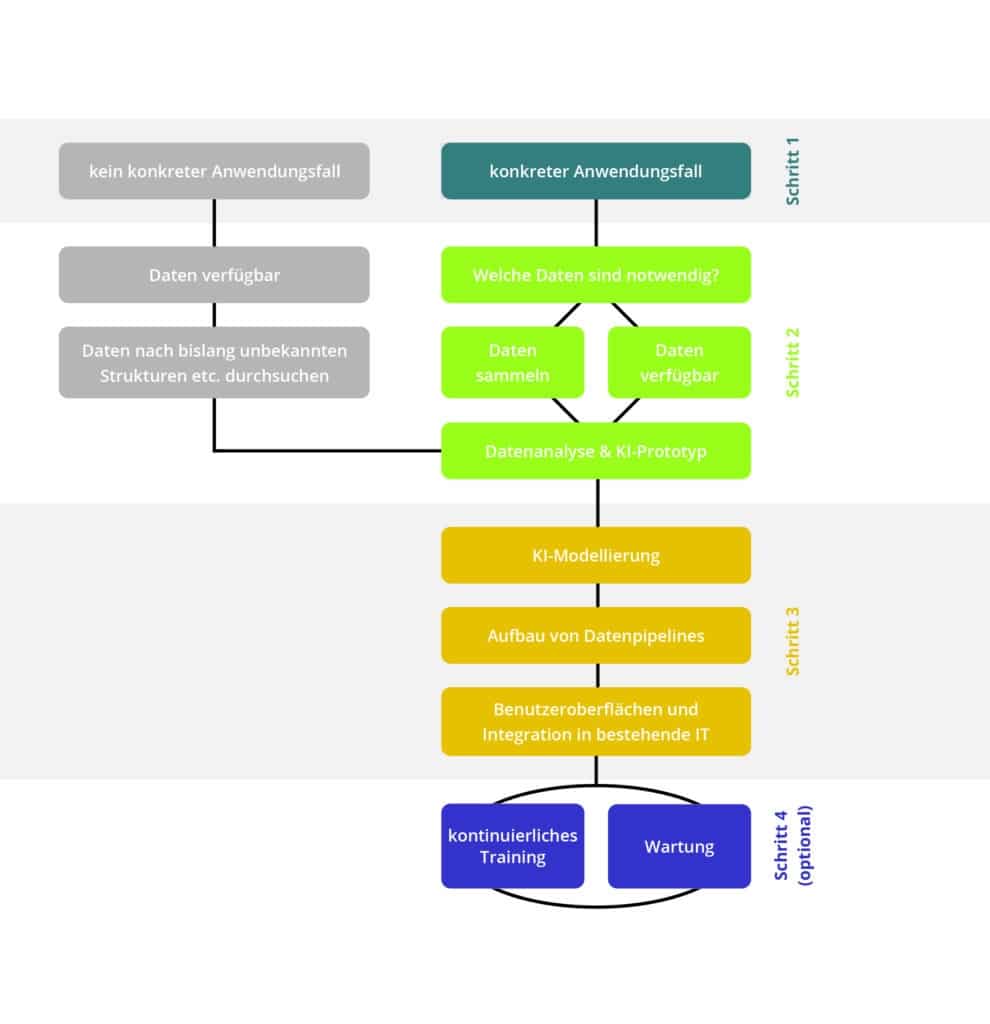

Dass der Einsatz von KI im Labor derzeit noch gering ist, hat drei Hauptgründe. Erstens: Zum Trainieren einer KI sind grosse Mengen digitaler Daten erforderlich. Viele Labore benötigen deshalb zunächst die passende Infrastruktur in Form vernetzter Laborgeräte und -software. Neben KI-Anwendungen sind hiermit erstmals auch Automatisierungen von Versuchen, Prozessen und Dokumentation möglich. Zweitens: Viele Unternehmen erkennen derzeit noch nicht, dass der Einsatz von KI als Lösungsweg für ihren Anwendungsfall infrage kommt. Drittens: Verantwortliche befürchten oft hohe Entwicklungskosten für die Entwicklung einer eigenen KI-Lösung. Diese Sorge ist bei strukturiert durchgeführten KI-Projekten unbegründet, denn sie folgen einem transparenten Vorgehen (Abb. 3):

- Domäne und Fragestellung: Grosse Datensammlungen auf gut Glück von einer KI nach Mustern durchsuchen zu lassen, liefert gelegentlich erstaunliche und hilfreiche Ergebnisse. Zielführender sind bereits identifizierte Probleme, Aufgaben oder Fragestellungen im Arbeitsalltag, anhand derer Datenwissenschaftler frühzeitig prüfen können, ob eine KI als Lösung sinnvoll ist. Aus dieser Analyse leitet sich auch die Projektstruktur mit einer transparenten Kosten- und Nutzenübersicht ab.

- Datenexploration: Bevor eine umfangreiche KI-Entwicklung startet, sind erste Datenanalysen sinnvoll. Sie benötigen weniger Daten, liefern aber häufig schon erste Antworten auf konkrete Fragestellungen. Ob Unternehmen die notwendigen Daten bereits gesammelt haben oder erst anfangen zu sammeln, hat allenfalls zeitliche Auswirkungen. Je besser die Qualität der Daten, desto besser das Ergebnis. Das gilt auch später für die Qualität der KI.

- Rapid Prototyping: Ein erstes KI-Modell gibt Aufschluss darüber, ob eine vollumfassende KI-Modellierung wirtschaftlich und inhaltlich sinnvoll ist.

- Training: Datenwissenschaftlerinnen trainieren ein robustes KI-Modell mit deutlich mehr Daten und evaluieren die Ergebnisse mit einem zweiten Datensatz.

- Nutzbarmachen der KI: Datenpipelines versorgen das Modell im Praxiseinsatz kontinuierlich mit Daten. Benutzeroberflächen dienen zur Steuerung und Auswertung der KI. Ergänzende Software kann die Ergebnisse der KI nutzen, um beispielsweise automatisiert Prozesse zu starten oder Meldungen zu verschicken.

Auch bei Microsynth durchlaufen sie derzeit dieses Schema. Sie haben von den Datenspezialisten von infoteam ein positives Feedback und eine Hausaufgabe bekommen: Damit die KI später die Massenspektren eigenständig beurteilen kann, benötigt das Modell Spektren verschiedenster Oligos als Datenbasis zum Lernen. Naheliegend ist, die Daten der vielen täglichen Messungen nun systematisch zu speichern und mit den Labels «korrektes Spektrum» oder «auffälliges Spektrum» zu versehen.

Thomas Eichmann, Business Development Manager, Stefan Förstel, Lead Data Scientist, Patrick Kraus, Marketing Communications Manager, infoteam Software AG